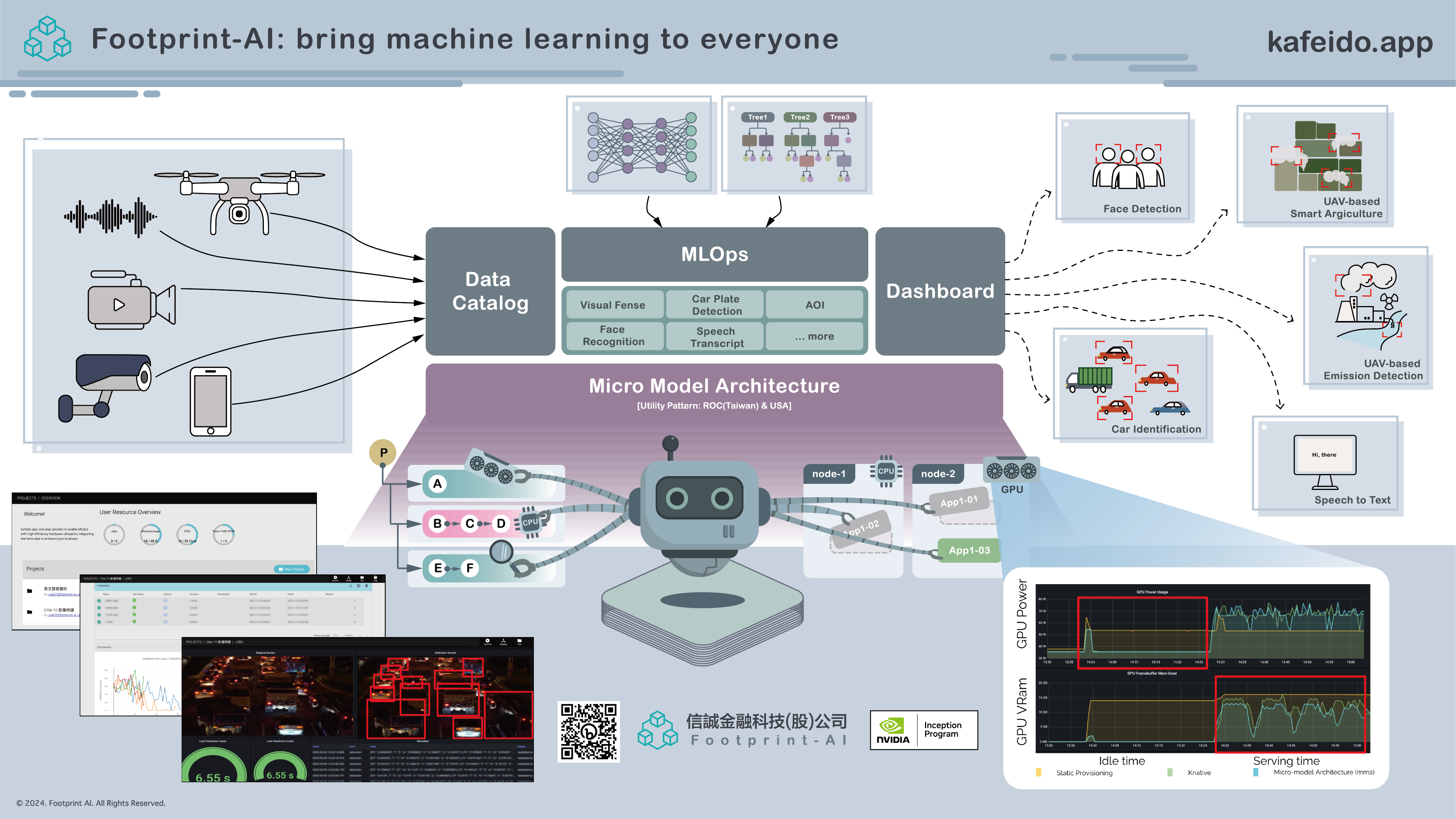

Kafeido.app

Kafeido.app is a machine learning platform developed by Footprint-AI, an AI company specializing in sustainable AI/ML solutions. Launched in December 2022, Kafeido.app aims to make AI and machine learning applications more efficient and environmentally friendly by reducing computational resource requirements and enhancing hardware utilization

Home

Home